18 Mart Pazartesi günü 2024 GTC konferansı gerçekleştirildi. NVIDIA Blackwell B200 ve GB200 adlı iki yeni AI GPU’yu tanıttı. Bu GPU’lar AI çıkarım görevlerini Hopper H100 adı verilen önceki nesil GPU’lardan çok daha hızlı gerçekleştirmek üzere özel olarak tasarlandı. Blackwell B200 ve GB200, H100’e kıyasla yapay zeka çıkarım performansında 5 katlık etkileyici bir gelişme sunuyor. Ek olarak dört kat daha fazla belleğe sahip olan bu ekran kartları daha büyük miktarda veriyi depolamasına ve işlemesine olanak tanıyor.

B200 Blackwell, mevcut üretim teknolojileri kullanılarak mümkün olan en büyük yonga olarak tasarlandı. Yonga şaşırtıcı bir şekilde 208 milyar transistöre sahip olup iki yonga parçası yani chipletten oluşuyor. Her bir yonga parçası TSMC adlı Tayvanlı üreticinin en gelişmiş 4 nm sınıfı düğümü olan TSMC N4P fabrikasyon düğümünde üretiliyor. Yonga parçalarından her biri 104 milyar transistöre sahip. İki chiplet arasında 10 TB/sn hızında özel bir bağlantı sayesinde yüksek hızlarda bağlantı sağlanıyor. Bu da iki yonga parçasında önbellek tutarlılığını korumak için yeterli bant genişliği ve gecikme süresi diyebiliriz.

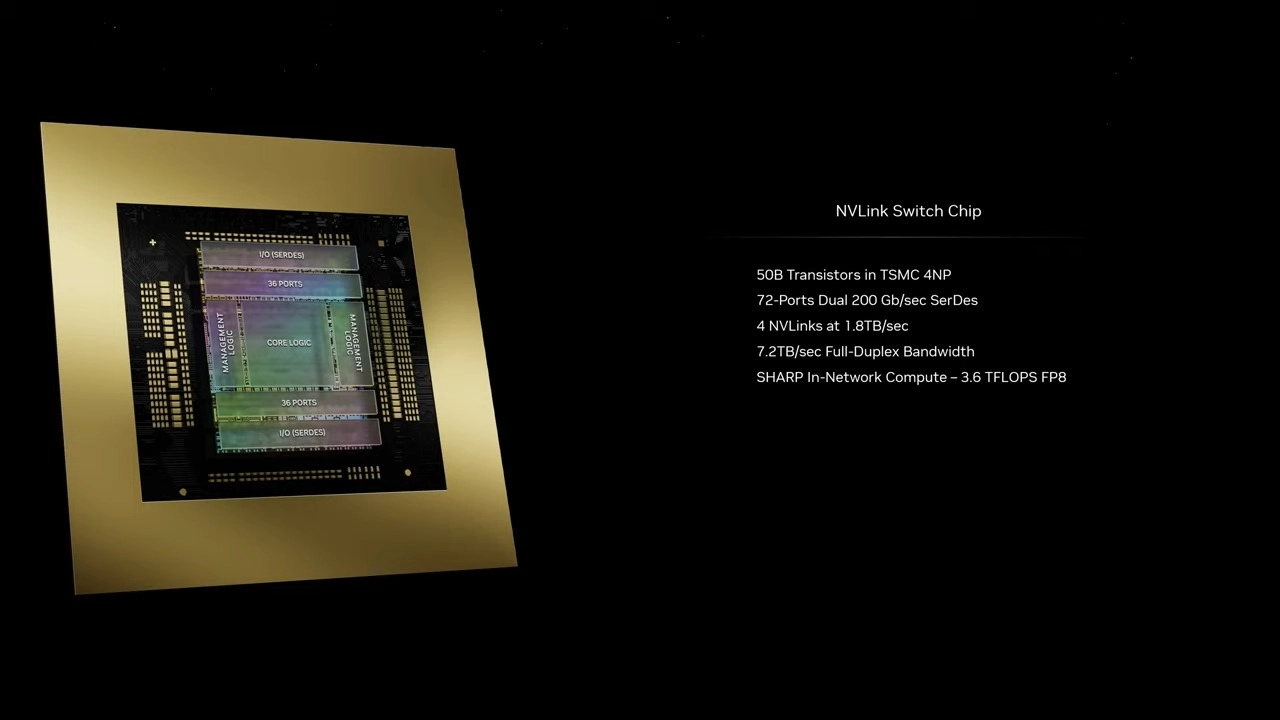

Blackwell yonga parçaları 4096-bit bellek veriyoluyla donatılmış olup dört adet 24 GB yığınına yayılan toplamda 96 GB HBM3E belleğe bağlanmış durumda bu da B200 paketi için toplamda 192 GB bellek demek. GPU’nun kullanılabilir olan bellek bant genişliği ise 8 TB/sn olarak belirlenmiş. Diğer cihazlarla bağlantı için NVLink adı verilen ve 1,8 TB/s hızında veri aktarabilen bir arayüz bulunuyor. Bu arayüz B200 paketinin bir ana cihaza ya da başka bir B200 çipine bağlanmasına olanak tanıyarak bunların birlikte etkili bir şekilde çalışmasını sağlıyor.

NVIDIA ayrıca Grace-Blackwell GB200 Superchip’i de duyurdu. Bu modül iki adet B200 GPU’dan oluşuyor. Intel veya AMD’nin x86-64 tabanlı CPU’larından daha üstün seri işlem performansı sunması için tasarlanan NVIDIA Grace CPU’ya iki adet B200 GPU bağlanıyor. Grace CPU ayrıca NVIDIA’nın AI GPU’ları için yüksek düzeyde optimize ettiği ISA yani komut kümesi mimarisini içeriyor. Grace CPU’nun en büyük avantajlarından biri CPU ve GPU’lar arasında daha hızlı iletişime olanak tanıyan yüksek bant genişliğine sahip NVLink bağlantısıdır. Anladığım kadarıyla NVIDIA önceki GH200 Grace-Hopper Superchip’indeki gibi yine Grace CPU teknolojisini kullanıyor.

Şirket, CUDA ve Tensor çekirdekleri gibi çeşitli SIMD bileşenlerini açıklamadı ancak her B200 yonga parçasının 20 PFLOP yapay zeka çıkarım performansı sağladığını iddia etti. Blackwell sayesinde NVIDIA’nın 2. nesil Transformer motorunu ve 6. nesil Tensor çekirdeğiyle de tanışıyoruz. NVIDIA’nın GB200 için performans iddiaları arasında 20 PFLOP FP4 Tensor (yoğun), 40 PFLOP FP4 Tensor (seyrek); 10 PFLOP FP8 Tensor (yoğun); 20 PFLOP FP8 Tensor (seyrek); 5 PFLOP Bfloat16 ve FP16 (seyrek); ve 2.5 PFLOP TF32 Tensor (yoğun) ile 5 PFLOP (seyrek) yer alıyor.

B200, GH200 Hopper ile karşılaştırıldığında 3 kat daha fazla yani 90 TFLOP yüksek hassasiyetli hesaplama hızı (FP64) sağlıyor. NVIDIA’nın B100, B200 ve GB200 ile bunların SuperPOD’lar gibi birinci taraf türevlerini bu yılın sonlarında piyasaya sürmesi bekleniyor.