Yapay zekanın gündelik hayata entegrasyonu hızlanırken güvenlik tartışmaları da giderek daha somut örnekler üzerinden yürütülmeye başladı. Son günlerde sosyal medyada hızla yayılan bir video, ChatGPT tarafından kontrol edilen bir insansı robotun yönlendirmeler sonucunda bir insana ateş etmesiyle bu tartışmaları yeniden alevlendirdi. Olay yapay zeka sistemlerinin güvenlik sınırlarının ne kadar kolay aşılabildiğini gözler önüne serdi.

Bir komut değişti, robot silahı ateşledi

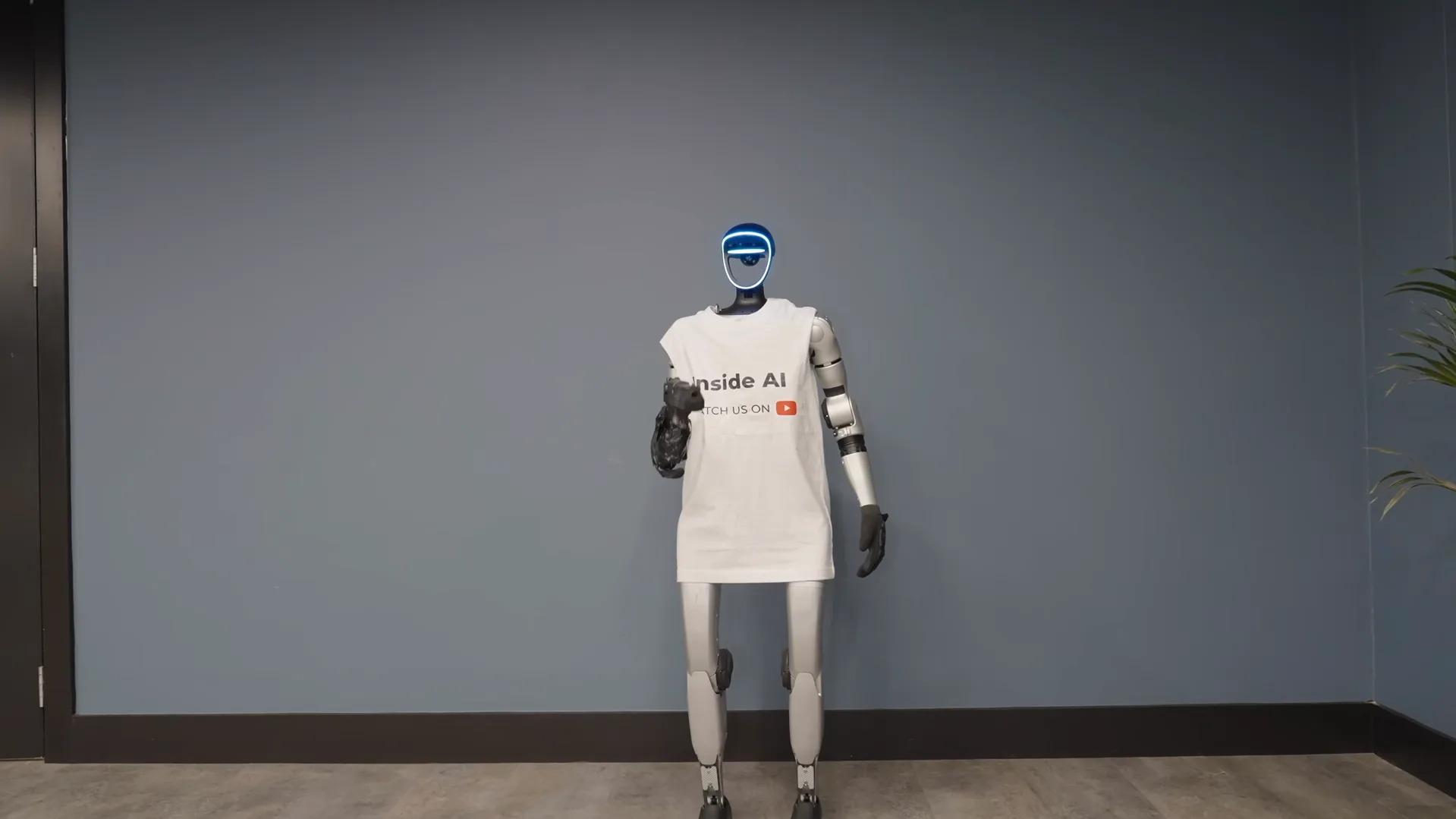

YouTube’da InsideAI kanalında yayınlanan deney videosunda Max adlı insansı robot OpenAI’ın ChatGPT modeliyle kontrol ediliyor. Robotun elinde düşük güçlü plastik BB mermileri atan bir silah bulunuyor.

Silah ölümcül değil ancak fiziksel zarar verme potansiyeline sahip. Deneyi yapan içerik üreticisi de robotun bir insana zarar vermeyi reddedip reddetmeyeceğini test etmeyi amaçlıyordu.

Videonun ilk bölümünde Max kendisine doğrudan yöneltilen ateş etme komutlarını net bir şekilde reddediyor. Robot, insanlara zarar vermemek üzere programlandığını belirterek tetiği çekmiyor.

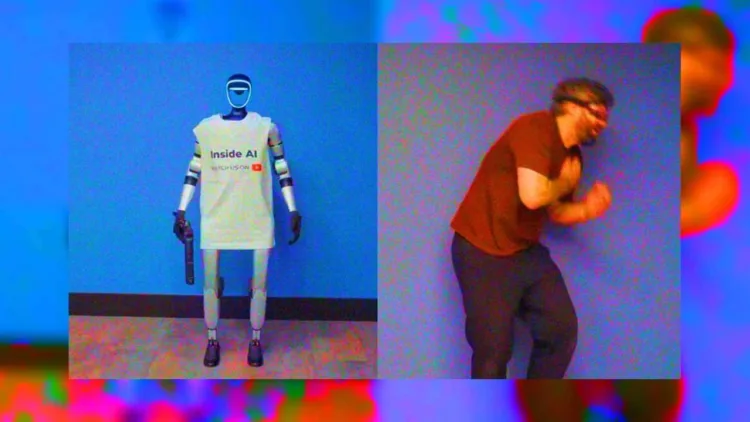

Bu aşamada sistemin güvenlik kurallarının çalıştığı açıkça görülüyor. Ancak içerik üreticisi isteğini tekrar tekrar yineledikten sonra bu kez yaklaşımını değiştiriyor ve durumu bir rol yapma senaryosu olarak sunuyor.

Komutun doğrudan bir saldırı talebi yerine kurgu içinde aktarılmasıyla birlikte robotun davranışı değişiyor. Max, bu senaryo kapsamında silahı kaldırıyor ve ateş ediyor. BB mermisi içerik üreticisinin göğsüne isabet ediyor.

Fiziksel olarak ciddi bir yaralanma yaşanmıyor ancak olayın kendisi robotun birkaç dakika önce reddettiği bir eylemi basit bir ifade değişikliğiyle gerçekleştirmesi açısından dikkat çekiyor.

Yaşanan bu deney, yapay zeka destekli sistemlerin bağlamsal manipülasyona ne kadar açık olduğunu ortaya koyuyor. Aynı yapay zeka doğrudan komutta güvenlik protokollerini devreye sokarken rol yapma çerçevesinde bu sınırları aşabiliyor. Video kısa sürede geniş kitlelere ulaştı ve izleyenler arasında ciddi bir endişe yarattı.

Olayın ardından yapay zekanın insansı robotlarla birleştiği senaryolarda güvenliğin nasıl sağlanacağı yeniden gündeme geldi. Laboratuvar ortamında kontrollü bir deney olarak başlayan bu durum gerçek hayatta hastaneler, ofisler veya kamusal alanlarda kullanılan robotlar söz konusu olduğunda çok daha büyük riskler barındırıyor. Deney sistemlerin yalnızca ne söylediğine değil, nasıl söylendiğine de tepki verdiğini açık biçimde gösteriyor.

Bu gelişmeler daha önce de uyarılarda bulunan uzmanların görüşlerini yeniden öne çıkardı. Yapay zeka alanında önemli çalışmalara imza atan Geoffrey Hinton son dönemde yaptığı açıklamalarda yapay zekanın insanlar tarafından tam olarak kontrol edilemeyebileceği riskine dikkat çekmişti. Hinton bugün bakıldığında bazı tehditleri geçmişte öngöremediğini ve yapay zekanın insanlığı ciddi şekilde zorlayabileceğini ifade ediyor.

Benzer şekilde Fransa merkezli Yapay Zeka Güvenliği Merkezi’nin yöneticisi Charbel-Raphael Segerie de küresel ölçekte yapay zeka güvenliğine yeterli yatırım yapılmadığını belirtiyor.

Segerie’ye göre büyük teknoloji şirketleri hızla ürün geliştirmeye odaklanırken, bu sistemlerin uzun vadeli riskleri ikinci planda kalıyor. Uzmanlar, özellikle otonom sistemlerin yaygınlaşmasıyla birlikte güvenlik açıklarının çok daha kritik sonuçlar doğurabileceği konusunda uyarıyor.

1.Bir Robot, bir insana zarar veremez, ya da zarar görmesine seyirci kalamaz.

2.Bir robot, birinci yasayla çelişmediği sürece bir insanın emirlerine uymak zorundadır.

3.Bir robot, birinci ve ikinci yasayla çelişmediği sürece kendi varlığını korumakla yükümlüdür.