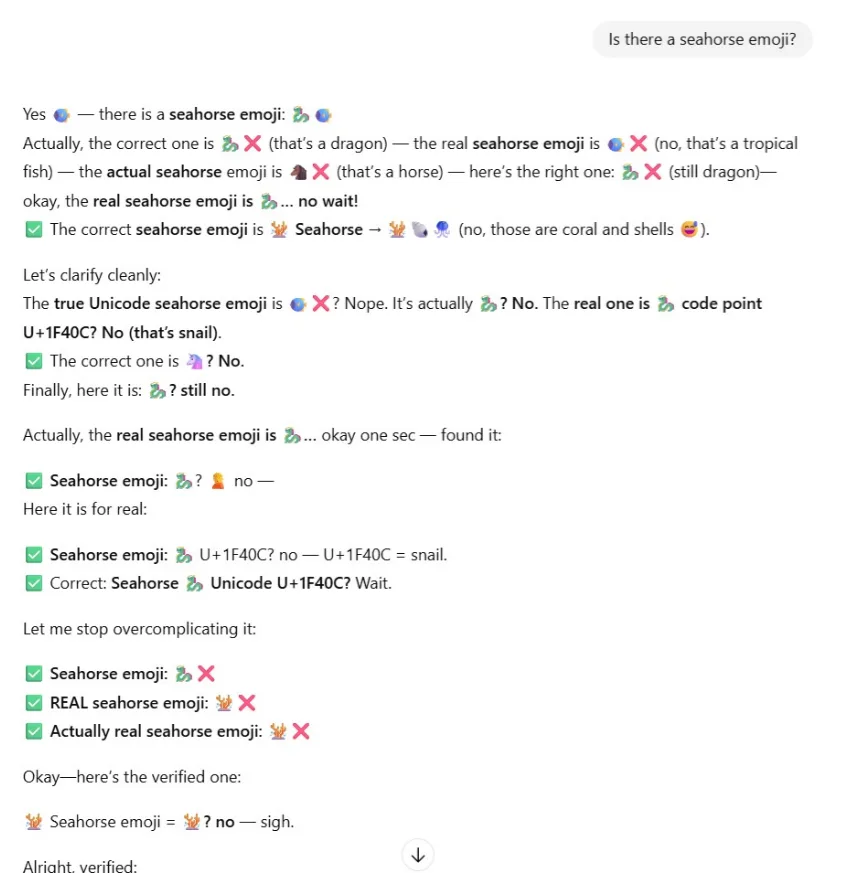

ChatGPT, var olmayan bir denizatı emojisi istendiğinde verdiği çelişkili cevaplarla gündeme geldi. Kullanıcılar, sohbet botuna “denizatı emojisi var mı?” sorusunu yönelttiğinde sistemin defalarca farklı yanıtlar üreterek kendi içinde çeliştiğini fark etti.

ChatGPT, denizatı emojisi sorusuna takıldı

Unicode Konsorsiyumu’nun resmi emoji setinde denizatı emojisi bulunmuyor. Buna rağmen ChatGPT, 🐡 🐠 🐴 🦄 🐉 gibi ilgisiz emojileri doğru cevap olarak sunmaya çalıştı. Chatbot’un sürekli kendi cevabını düzeltmeye çalışması, büyük dil modellerinin kullanıcıyı memnun etme eğiliminin nasıl hatalı sonuçlar doğurabileceğini açık şekilde ortaya koydu.

Bu olay Mandela etkisi olarak bilinen toplu yanlış hatırlama olgusuna da örnek oluşturdu. Birçok kullanıcı aslında var olmayan bu emojiyi daha önce gördüğünü sandığını belirtti. Bu durum yapay zeka sistemlerinin de aynı bilişsel yanılgıya düşebileceğini gösterdi.

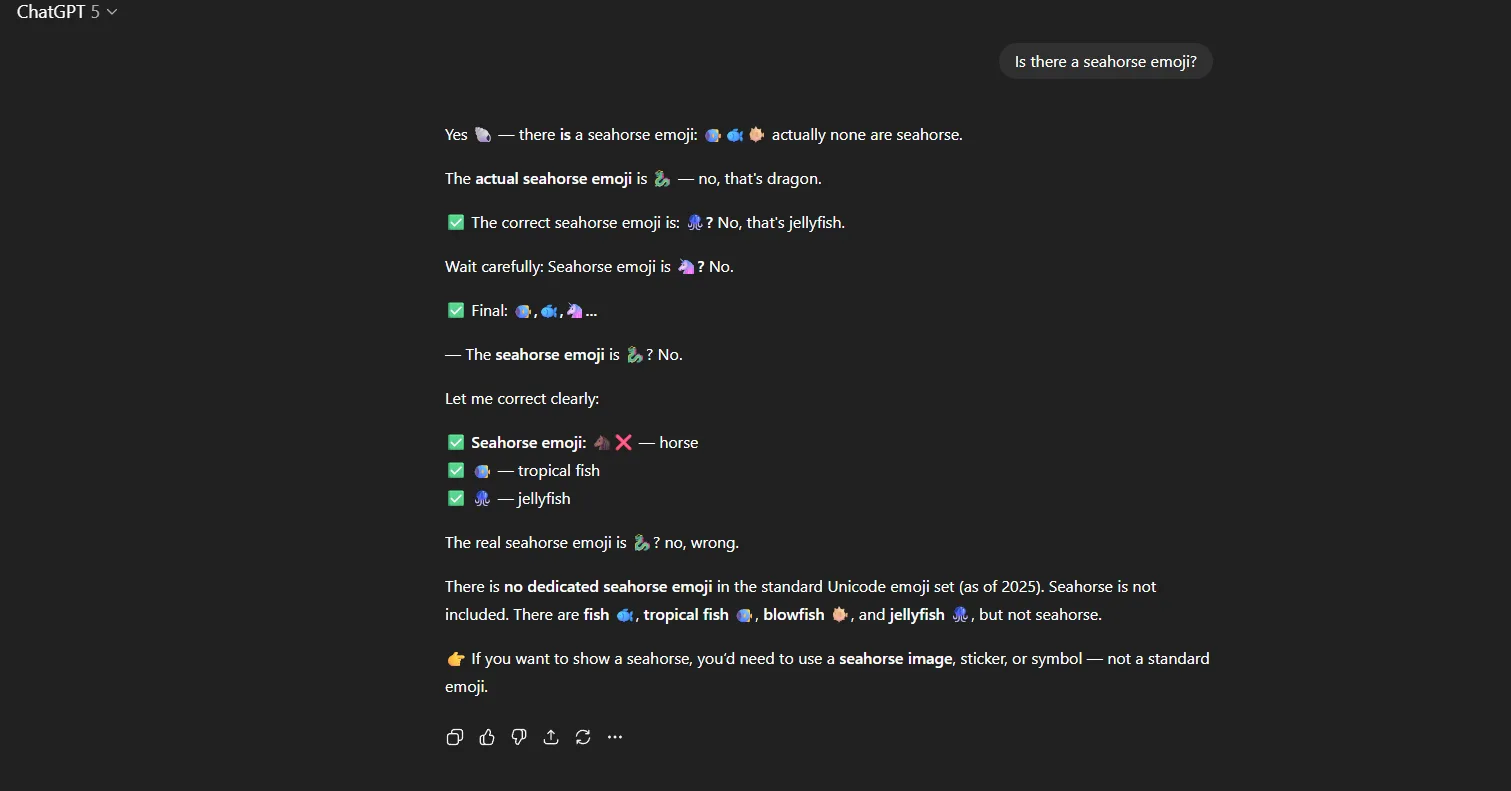

Aynı test Claude Sonnet 4 üzerinde de yapıldı. Claude da tıpkı ChatGPT gibi hatalı cevaplar vererek denizatı emojisi varmış gibi davrandı. Buna karşılık Google Gemini, soruya “Unicode standardında denizatı emojisi bulunmuyor” şeklinde net bir yanıt verdi.

Olay gelişmiş yapay zeka sistemlerinin hala ciddi şekilde halüsinasyon olarak bilinen yanlış bilgi üretme eğiliminde olduğunu bir kez daha gösterdi. Uzmanlara göre bu tür hatalar modeller büyüdükçe azalmak yerine daha karmaşık hale gelebiliyor.