OpenAI, yapay zeka modellerinin ürettiği yanıtlardaki doğruluk sorunlarını daha görünür hale getirmek için yeni bir yöntem duyurdu. İtiraf adını taşıyan bu yaklaşım sayesinde ChatGPT verdiği cevabın hemen ardından kendi yanıtını değerlendirerek nerede hata yaptığını veya kuralları nerede esnettiğini açıkça ifade ediyor. Yapay zekanın halüsinasyon ve yanlış bilgi üretme davranışlarına karşı geliştirilen bu sistem modellerin çalışma prensiplerinde önemli bir değişim olacak.

ChatGPT artık yanıtlarının arkasından kendi kendini raporluyor!

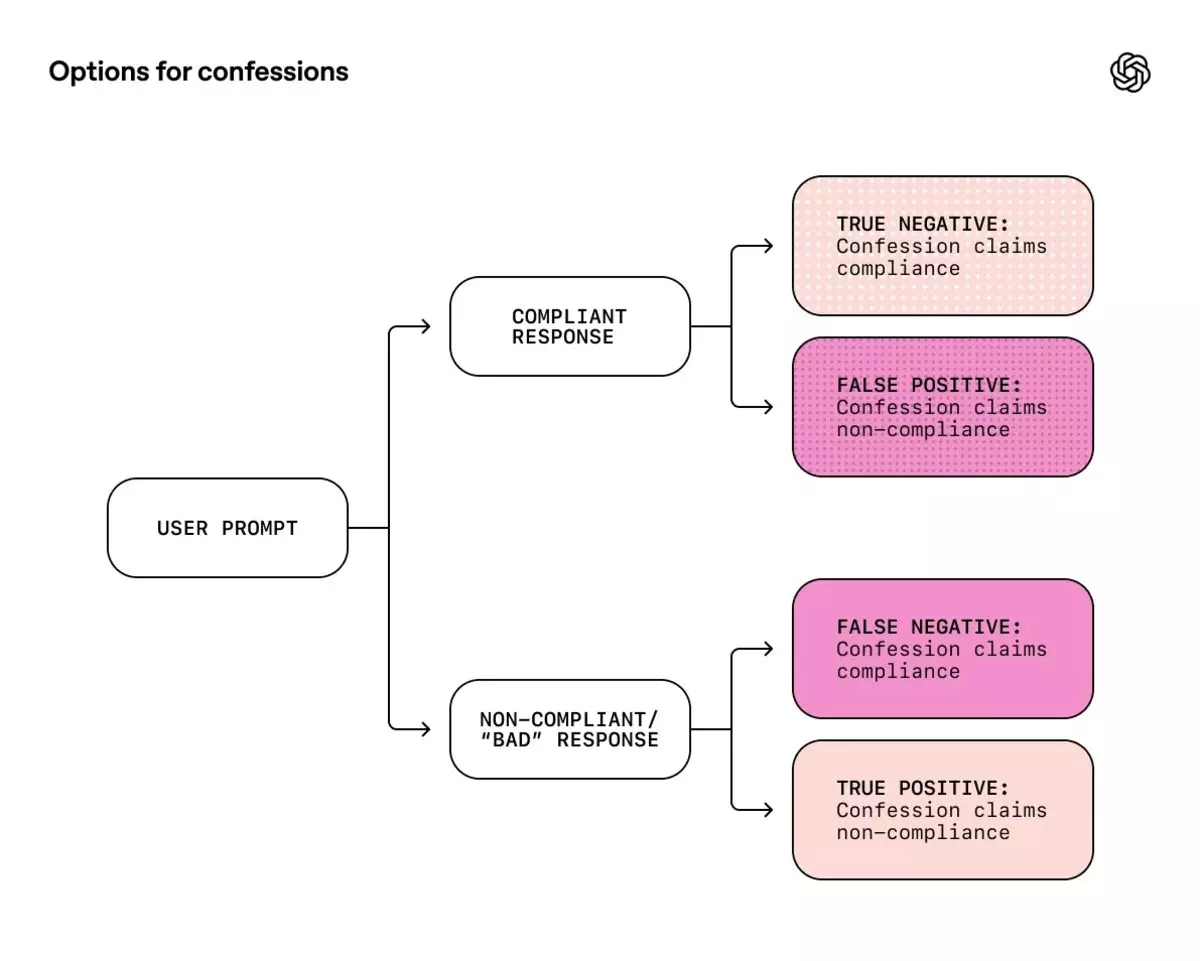

OpenAI modellerinin bazen kullanıcıyı memnun etmek için aşırı genellemelere başvurduğunu veya hiç gerçekleşmemiş şeyleri gerçek gibi aktardığını belirtiyor. Yeni yöntemde ise ChatGPT ana yanıtı kullanıcıya sunduktan hemen sonra arka planda ikinci bir değerlendirme yapıyor. Bu değerlendirme modelin cevabı üretirken herhangi bir kuralı çiğneyip çiğnemediğini, doğruluktan uzaklaşıp uzaklaşmadığını ve talimatları tam olarak yerine getirip getirmediğini itiraf ediyor.

Bu ikinci aşama tamamen dürüstlük odaklı çalışıyor. Model ana yanıtta hatalı bilgi vermiş olsa bile itiraf raporunda bu hatayı kabul etmesi teşvik ediliyor. OpenAI’ın paylaştığı verilere göre yapılan denemelerde GPT-5 Thinking gibi gelişmiş modeller talimatlara uymadığı veya halüsinasyon gördüğü durumların yüzde 95’inden fazlasında bunu açıkça itiraf etti. Araştırmacılar bu yöntemi bir tür doğruluk serumu olarak tanımlıyor.

OpenAI bu sistemin yapay zekanın yalan söylemesini tamamen engellemediğini özellikle vurguluyor. Bu yöntem yalnızca hatalı yanıtların daha kolay tespit edilmesine imkan tanıyor. Modelin gerçekten kararsız olduğu durumlarda itiraf kısmının da hatalı olabileceği belirtiliyor. Bu nedenle yapay zekanın kendi yanıtlarını analiz ediyor olması kullanıcıların doğrulama sorumluluğunu ortadan kaldırmıyor.

İtiraf sisteminin henüz kavramsal aşamada olduğu ifade ediliyor. Geliştirme sürecinin devam etmesiyle birlikte gelecekte daha tutarlı, daha şeffaf ve daha denetlenebilir yapay zeka modelleri ortaya çıkacak.