AMD'ye güvenim sonsuz ama Intel....

Son kullanma tarihi geçmiş, bayatlamış bir tarayıcı kullanıyorsanız, Mercedes kullanmak yerine tosbağaya binmek gibi... Web sitelerini düzgün görüntüleyemiyorsanız eh, bi' zahmet tarayıcınızı güncelleyiniz.

Modern Web standartlarını karşılayan bir tarayıcı alternatifine göz atın.

Modern Web standartlarını karşılayan bir tarayıcı alternatifine göz atın.

Intel CEO’su: “Moore Yasası’nın Önüne Geçeceğiz”

- Konuyu başlatan Ali Güngör

- Başlangıç Tarihi

- Mesaj 18

- Görüntüleme 1.421

Ayrıntılı düzenleme

Kim cevapladı?- Katılım

- 2 Haziran 2015

- Mesajlar

- 14.295

- Makaleler

- 110

- Çözümler

- 121

nm düşürmeden bile bir işlemcide performansı arttırmanın yolları var. Hem de ciddi kazançlar sağlayabilecek.

Sonuçta işlemci sadece çekirdekten oluşmuyor.

Sonuçta işlemci sadece çekirdekten oluşmuyor.

Son düzenleyen: Moderatör:

- Katılım

- 29 Mart 2021

- Mesajlar

- 24.631

- Makaleler

- 8

- Çözümler

- 153

Pek anlamadım, tüketiciye fiyat anlamında yarayan bir durum var mı?

Daha fazla

- Cinsiyet

- Erkek

- Meslek

- Öğrenci

Işlemci sadece çekirdekten oluşmuyor ancak yapısı gereği elektronlara bağlı çalışıyor. Transistörler çok küçültülürse kuantum prensiplerinden ortaya çıkan kuantum tünelleme durumu yüzünden elektronun önü kesilse bile(transistör kapalı veya 0 konumunda) karşı tarafa atlama olasılığı var. Bu olay da hatalı sonuçlar çıkmasına sebep oluyor.nm düşürmeden bile bir işlemcide performansı arttırmanın yolları var. Hem de ciddi kazançlar sağlayabilecek.

Sonuçta işlemci sadece çekirdekten oluşmuyor.

Kuantumdaki bilgimiz sınırlı olduğundan bunu engellemenin veya neden olduğunun bir izahı henüz yok. Engellemenin yolu da yok. En fazla bir yere kadar küçültebilir ve oradan sonra kuantum evrenindeki dinamikler yüzünden işlemciden doğru sonuç alamazsınız.

Bu durumun yaşanmasına hala zaman var, daha sınıra gelmedik ancak her geçen gün daha da yaklaşıyoruz. O sınıra geldiğimizde ise ya frekansı arttırmak gerekecek ancak arttırdığınız oranda stabilite, ısı ve enerji tüketimi olarak yansır. Onun haricinde çipin kapladığı hacmi arttırmak gerekir ki özellikle telefon gibi cihazlarda her milimetrenin önemli olduğunu hesaba katarsak bunun pek mümkün olmadığını görürüz.

Illaki yapılır ancak son tüketici ürünlerde göremeyebiliriz. Sırf her damla performans için aşırı frekansı arttırılıp sıvı azot ile soğutulan veya bütün kocaman bir PCB'yi kaplayan bir işlemci görebiliriz. Alternatif bir teknoloji geliştirilmediği veya elektronların tünelleme yapması engellenmediği sürece işlem kapasitemiz sabitleşebilir.

- Katılım

- 2 Haziran 2015

- Mesajlar

- 14.295

- Makaleler

- 110

- Çözümler

- 121

Işlemci sadece çekirdekten oluşmuyor ancak yapısı gereği elektronlara bağlı çalışıyor. Transistörler çok küçültülürse kuantum prensiplerinden ortaya çıkan kuantum tünelleme durumu yüzünden elektronun önü kesilse bile (transistör kapalı veya 0 konumunda) karşı tarafa atlama olasılığı var. Bu olay da hatalı sonuçlar çıkmasına sebep oluyor.

Burada şu sorunun sorulması gerekiyor: Amaç sadece nm'yi düşürmek mi yoksa güçlü, enerji verimliliği yüksek ve maliyeti karşılanabilir bir işlemci üretmek mi?

ARM'nin yaptığı bu işte. ARM'nin bu başarısının sadece düşük nm ile alakası yok. Komut setleri, işlemciyi tasarlama biçiminiz, RAM/Bellek yöneticilerinin tasarımları, ön bellek tasarımı, entegre encıder/decoderlar. Bunun yanında RISC yapısı, big.LITTLE mimarisi de büyük bir etken. Apple'ın Unified Memory ile bellek kullanımı yüksek olan uygulamalarda, ciddi bir kazanç sağladığı ortada. Bu gibi teknolojilik yenilikler, işlemcilerin performansını ve verimliliğini arttıracak şeyler.

Neden işlemcilerin birden fazla çekirdekten oluştuğunu düşündünüz mü hiç?

Burada firmaların amacının nm düşürmek değil, daha hızlı ve verimli işlemciler üretmek olduğunu unutmamak lazım. Bu nedenle nm işlemciler için uzun bir süre engel olmayacak, atıyorum 5 nm değerinde takılı kalsak bile. Çünkü işlemcilerin hala gelişebilecekleri pek çok alanları var.

Kuantumdaki bilgimiz sınırlı olduğundan bunu engellemenin veya neden olduğunun bir izahı henüz yok. Engellemenin yolu da yok. En fazla bir yere kadar küçültebilir ve oradan sonra kuantum evrenindeki dinamikler yüzünden işlemciden doğru sonuç alamazsınız.

Çok bilgili değilim ancak mevcut ya da öngörülen Kuantum işlemciler, FPGA'ler gibi olacak. En azından benim gördüğüm durum bu. Aslında kuantum işlemcilerin bir düzeni var ancak bu, mevcut dijital düzene yani "Binary" düzene benzemiyor. Bundan, Şubat ayında Technopat için yazdığım yazımda bahsetmiştim:

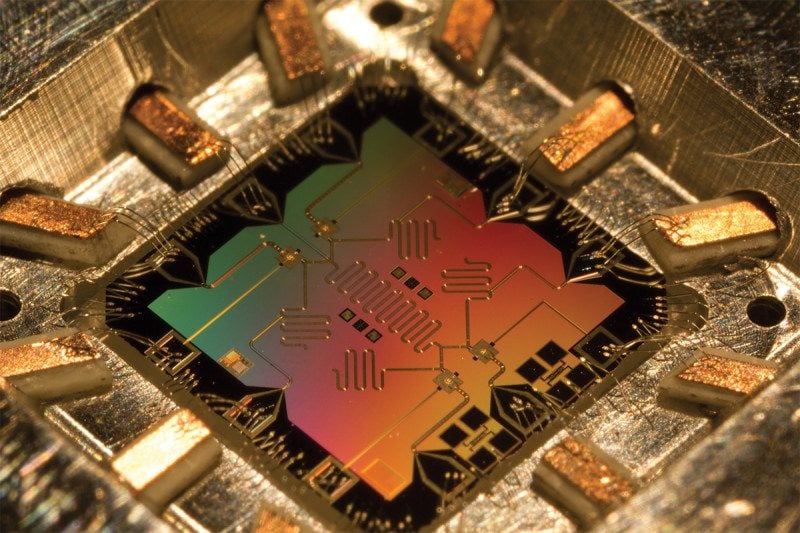

CPU, TPU ve QPU Nedir?

Geleneksel bilgisayarlardaki CPU, yapay zeka işlemcisi TPU ve kuantum işlemci QPU'ya yakından bakıyoruz. Delikli kartların ve hesap makinesinin icadıyla

www.technopat.net

www.technopat.net

Bu durumun yaşanmasına hala zaman var, daha sınıra gelmedik ancak her geçen gün daha da yaklaşıyoruz. O sınıra geldiğimizde ise ya frekansı arttırmak gerekecek ancak arttırdığınız oranda stabilite, ısı ve enerji tüketimi olarak yansır. Onun haricinde çipin kapladığı hacmi arttırmak gerekir ki özellikle telefon gibi cihazlarda her milimetrenin önemli olduğunu hesaba katarsak bunun pek mümkün olmadığını görürüz.

Bunlara gerek yok zira işlemcilerle beraber kullanılan OS'ler ve yazılımlar da değişecek. Artık işlemcilere entegre olan encode/decoder'ların, yapay zeka işlem birimlerinin, çeşitli kompleks hesaplama birimlerinin önemi artacak. Mesela Apple, yeni Apple ile kendi ProRes codecinin encoder/decoder ini işlemcisine entegre etti. Bu, yazılımlarda ciddi bir hızlılık sağlıyor.

Telefonlarda da yazılımsal olarak çalışan bir çok işlem, SoC yapıdaki işlemcinin bölümlerine entegre edilecek.

Bunun en iyi örneğini Double Precission'a sahip olan STM32 ve olmayan STM32 işlemciyle yaşadım. Aşırı Float/Double'a sahip bir kod çalıştırdığımda, Percission ünitine sahip işlemci hiç zorlanmazken, ünite sahip olmayan işlemci bu eksikliği yazılımsal olarak kapatmaya çalıştığı için (bir tür emülatör çalıştırmak gibi), tüm sistem kaynağını tüketti.

Be aware: Floating Point Operations on ARM Cortex-M4F

My mantra is *not* to use any floating point data types in embedded applications, or at least to avoid them whenever possible: for most applications they are not necessary and can be replaced by fi…

mcuoneclipse.com

mcuoneclipse.com

Why float data type is not accurate on a STM32?

I'm using STM32F103C8T6 and my compiler is KEIL 5. I have written a simple program to check something but I found out an interesting point. When I download the program to the MCU, aaa and bbb have ...

Apple'ın bir sürü güvenlik, haptic, Bluetooth, cart curt çipini çıkartmasının bir sebebi de bu. Çünkü bir işi ne kadar kod seviyesinden transistör seviyesine yaklaştırırsan, sisteme bindirdiği yük o kadar azalır.

İlla ki yapılır ancak son tüketici ürünlerde göremeyebiliriz. Sırf her damla performans için aşırı frekansı arttırılıp sıvı azot ile soğutulan veya bütün kocaman bir PCB'yi kaplayan bir işlemci görebiliriz. Alternatif bir teknoloji geliştirilmediği veya elektronların tünelleme yapması engellenmediği sürece işlem kapasitemiz sabitleşebilir.

Kullandığımız yazılımın ve işlemci mimarisinin evrim geçirmesi gerekecek.

Dediğim gibi, nm bir sorun değil. İşlemcinin performansını etkileyen onlarca faktörden birisi.

Son düzenleme:

Daha fazla

- Cinsiyet

- Erkek

- Meslek

- Öğrenci

Anlamadı veya ben anlatamadım. Ben işlemcilerin fiziksel olarak geldiği sınırlardan dolayı ilerleyemeyeceğini söyledim. Ibrahim ise yazılım gibi birçok detaya girmiş. Ibrahim optimizasyonla açıklamaya çalışmış. Optimizasyonlar sınırları aşmak değil, var olan sınırlar içerisinde en iyisini yapmaya çalışmaktır.Açıkçası bu yazıdan sonra karşı tarafın nokta ile bile karşı koyası gelmemiştir.

Dostum o ne öyle sanki bir yarışmaya katılır gibi...

Şu şekilde örneklendirebiliriz. Yakıttan itkiye çevirebileceğiniz enerjinin sınırı bellidir. 100% verime çıkamazsınız hatta en fazla erişebileceğiniz 70% civarıdır. Işlemcilerde artık bu sınıra yaklaşıyoruz. Daha fazla transistör sıkıştırılamayacak çünkü imkansız. Kuantum tünelleme engellenmediği sürece imkansız, kuantum hakkında bilgilerimiz sınırlıyken daha sıkıştırmak mümkün değil. Ibrahim'in bahsettiği olaylar ise var olanı daha verimli kullanmaya çalışmak.

Jet motoru örneğimize geri dönelim. Maksimum verimde olduğumuzu düşünelim. Motordan parçalar çıkarıp veya şeklini değiştirip kaybedilen enerjiyi asgari düzeye indirelim. Ibrahim'in bahsettiği şey işte bu, optimizasyon. Bir yere kadar yapılabilir ve belli kazanımlar elde edilebilir ama en sonunda ya motoru büyültmek veya alternatif çözümlere ilerlemek gerekecek. Işlemciye uyarladığımızda ya frekansı arttırmak ya da direkt işlemcinin kapladığı alanı arttırmak zorunluluk. Veya yeni bir teknoloji.

Kuantum bilgisayarları çözüm değil. Kuantum bitlerinin işlem doğruluklarını koruyabilmesi için mutlak sıfır seviyesine yakın şekilde soğutulması(-273 C°~) gerekli. Son tüketiciye gelmesi yıllar alır. Bunun haricinde kuantum bilgisayarlar hala deneysel ve bilimsel/askeri alanlarda kullanılmaktan bile uzakta.

- Katılım

- 2 Haziran 2015

- Mesajlar

- 14.295

- Makaleler

- 110

- Çözümler

- 121

Anlamadı veya ben anlatamadım. Ben işlemcilerin fiziksel olarak geldiği sınırlardan dolayı ilerleyemeyeceğini söyledim. Ibrahim ise yazılım gibi birçok detaya girmiş. Ibrahim optimizasyonla açıklamaya çalışmış. Optimizasyonlar sınırları aşmak değil, var olan sınırlar içerisinde en iyisini yapmaya çalışmaktır.

Bak benim başından beri tartıştığım şey nm değil. Benim kast ettiğim, nm düşürmeden de işlemcilerde büyük performans artışlarının olabileceği, bunu gelecekte sıklıkla görebileceğimiz. İşlemcide performans arttırmak sadece GHz'sinin yükseltmek değil ayrıca. Başından beri diyorum, amaç nm düşürmek değil performans arttırmak. İşlemcilerde hala optimize edilememiş ve hala düzgün ve verimli tasarlanamayan alanlar var. Bunun yanında zamanla donanımsal encoder/decoder tarzı yapıların sayısı da artacak.

Tüm bunların yanında, nm düşürmedeki ana engelin kuantum tünellemesi değil, üretim ve litografi olduğunu da belirtmek gerek. Quantum Tunneling, örnek olarak mutlak sıfır ise (–273,15 °Celsius) litografi ve üretim engelleri de o noktaya ulaşmanı engelleyen faktörlerdir. Bunu zaten kimse inkar etmiyor. Kendi kendine tartışıyorsun şu an.

Şu şekilde örneklendirebiliriz. Yakıttan itkiye çevirebileceğiniz enerjinin sınırı bellidir. 100% verime çıkamazsınız hatta en fazla erişebileceğiniz 70% civarıdır. Işlemcilerde artık bu sınıra yaklaşıyoruz. Daha fazla transistör sıkıştırılamayacak çünkü imkansız. Kuantum tünelleme engellenmediği sürece imkansız, kuantum hakkında bilgilerimiz sınırlıyken daha sıkıştırmak mümkün değil. Ibrahim'in bahsettiği olaylar ise var olanı daha verimli kullanmaya çalışmak.

Hayır, jet motoru ile işlemciler bu tarzda örneklendirilemez. Verimlilik konusunda örnekler verilebilir ancak jet motoru dediğimiz sistem, işlemciler gibi ya da işlemciler kadar ölçeklendirilebilir değildir.

Olanı verimli kullanmak, yazılımla olur. Ben sistemi baştan tasarlamaktan ve donanımsal özellikleri arttırmaktan bahsediyorum. Bu verimlilik değildir, optimizasyon da değildir. Bu kısaca yeni bir mimaridir. "Double Precission'a sahip olan STM32 ve olmayan STM32" örneğinde verdim. Bu optimizasyonla alakalı değil. Yazılımla bunu halledemezsin. Donanımsal olarak hallettiğin zaman ise sadede işlemcinin kullandığı güç ya da kaynak azalmaz, işlemin doğruluğu da artar.

Jet motoru örneğimize geri dönelim. Maksimum verimde olduğumuzu düşünelim. Motordan parçalar çıkarıp veya şeklini değiştirip kaybedilen enerjiyi asgari düzeye indirelim. Ibrahim'in bahsettiği şey işte bu, optimizasyon. Bir yere kadar yapılabilir ve belli kazanımlar elde edilebilir ama en sonunda ya motoru büyültmek veya alternatif çözümlere ilerlemek gerekecek. İşlemciye uyarladığımızda ya frekansı arttırmak ya da direkt işlemcinin kapladığı alanı arttırmak zorunluluk. Veya yeni bir teknoloji.

Optimizasyon bu değil ki hala işlemcide performans arttırmanın yolunu sadece alanı arttırmak ya da frekansı arttırmak olarak görüyorsun. Sana çekirdek örneğini vermiştim ve orada da bahsetmiştim. Aslında bir noktada transistör sınırına zaten ulaşıldı. Bu yüzden işlemciler birden fazla çekirdekle geliyor ve bu yüzden AMD'nin Threadripper gibi işlemcileri birden fazla Die ile tasarlanıyor:

Tekrar ediyorum, Kuantum tunneling transistörler için bir sorun. İŞlemciler için ondan önce gelen sorunlar mevcut ve hatta bugün bile kendilerini gösteriyorlar.

Transistörler, geometri kullanarak 1nm'ye kadar küçülme/ölçekleme yapabilirler. Zaten 2nm transistörler ve çipler tanıtılmıştı. 1 nm'nin altına inemeyiz zira o zaman yarım atom kullanarak nasıl transistör yapılacağını bulmanız gerekir. Bu da fiziki olarak imkansızdır.

Yani TSMC'ye göre, transistörler istiflenecekler. Bu yeni bir durum değil. İstifleme ile ilgili ana sorun ısı ve sıcaklıktır. Şİrketler ise on yıldan fazla bir süredir bunun üzerinde çalışıyorlar.

İşin garibi, çoğu cihazın buna ihtiyacı bile yok. Karma gerçeklik uygulamaları ya da devasa 8K AR sistemler gelmedikçe... O zaman işlem gücünü biraz artırmamız gerekebilir, ancak bundan sonra hepsi back end'de bitecek. 5G ya da karma gerçeklikte bile, işlemlerin çoğunu back end olarak yapabiliriz.

Bu yüzden endüstrinin nereye gittiğini görmek gerçekten ilginç olacak. Ancak işleme kapasitesini artırmak için istifleme yapacaklar.

Mevcut durum 5 nm transistörlere kayıyor, bu nedenle bir sonraki CPU için 7 nm'nin ötesindeyiz. AMD Zen+ yenilemesinin teknik olarak şu anda 12nm'lik bir düğümde olduğuna inanıyorum, bu yüzden 14nm'nin altında bazı güncel CPU'larımız bile var.

En büyük sorun, bağlantı telleri. Transistörler kadar iyi ölçeklenmezler. Daha küçük teller, daha küçük kesit alanı nedeniyle daha yüksek dirence sahiptir. Ayrıca, kabloları birbirine ne kadar yakınlaştırırsanız, kablolar arasındaki parazitik kapasitans o kadar yüksek olur. Bunların ikisi de kabloları yavaşlatır.

Yani, şu anda gördüğünüz şey, birbirine o kadar yakın toplayamayacağınız daha küçük, daha hızlı anahtarlamalı transistörler. Bazı enerji verimliliği avantajları elde edebilirsiniz, ancak beklediğiniz kadar alan yoğunluğu avantajı sağlayamazsınız.

Teknolojiyi ilerletmeye devam ediyoruz, ancak ölçeklendirme sınırlarına giderek daha fazla karşı çıkıyoruz.

Ki, quantumm tunneling dediğin şey vakum tüplerden CMOS transistörlere geçildiğinde bile yaşandı. Ancak bilim ve fizik, buna sürekli çözümler buldu. Gördüğün gibi, quantum tunneling hatta litografiye bile gelmeden, seni bağlantı kabloları sınırlıyor.

Nasıl işlemci seçerken sadece nm'ye bakmıyorsak, işlemcilerin geleceğini düşünürken ya da gelişebileceği alanları düşünürken de sadece nm'ye bakmamalıyız. Dediğim gibi, işlemcilerin gelişebileceği hala birçok alan var ve bunlar optimizasyon değil. Basitçe Intel'in x86 yerine RISC ya da RISC-V'ye geçmesi işte. Ya da grafen transistörler ya da Mn doped III-V yarı iletkenler ya da Galyum...

Şu an bilgisayarda ya da OS'de yaptığın birçok matematik ya da hesaplama işlemini yazılım katmanında yapıyorsun. Bir kere bunların işlemcilere donanımsal olarak entegre edilmesi, en az 10 senelik bir performans arttırımı sağlayabilir.

Kuantum bilgisayarları çözüm değil. Kuantum bitlerinin işlem doğruluklarını koruyabilmesi için mutlak sıfır seviyesine yakın şekilde soğutulması(-273 C°~) gerekli. Son tüketiciye gelmesi yıllar alır. Bunun haricinde kuantum bilgisayarlar hala deneysel ve bilimsel/askeri alanlarda kullanılmaktan bile uzakta.

K,imse çözüm demedi ancak kullanılamaz da değiller. FPGA'ler ile çok farklı mantıkları olsa da, aynı FPGA'lar gibi kullanım senaryosuna özel tasarlanabilirler. Büyük ölçekli fabrika ya da tesisleri düşündüğünde, tasarım ve üretim maliyetleri pahalı olsa da işletme maliyetleri, verdiği performansa göre aynı oranda kalır. Yani, en azından IBM ve Intel gibi şirketlerin hedeflediği ilk kilometre taşı, bu tür bir ürün ortaya çıkartmak.

Bunun haricinde kuantum bilgisayarlar hala deneysel ve bilimsel/askeri alanlarda kullanılmaktan bile uzakta.

Geliştirmeler devam ediyor. Burada ana sorun qubit mantığına göre bir mimari inşa etmek.

Şu an mevcut işlemcilerde, elektriksel verimliliğe gelmeden önce alan verimliliği ya da yazılımsal verimlilik konuları var. Bir başka konuda sana, Intel'in, çekideklerinin temelinde RISC-V kullandığını söylemiştim. Önümüzdeki 10 - 20 - 30 senelik süreçte de mimariler gelişmeye devam edecek.

Son olarak şu konuya dikkat çekmek isterim. Sen nm'nin sınırının olduğunu belirtiyorsun ve haklısın, bu sınır var ve kimse inkar etmiyor. Ancak benim kast ettiğim, bu sınıra rağmen nm düşmese bile performans artışının katlanabileceği.

Daha fazla

- Cinsiyet

- Erkek

- Meslek

- Öğrenci

@SideWinder, sorularınızın zaten cevabını verdim. Dediğiniz şey optimizasyon olur. Var olanın suyunu sıkıyorsunuz. Tankınız 1500 beygirse 1500 beygirdir. Daha hızlı gitmesini istiyorsanız ağırlık atabilirsiniz ama bir yere kadar. Bir yerde tıkanacak. Optimizasyon çözüm olsa kuantum bilgisayarlarını düşünmemize bile gerek kalmazdı. Araya fazladan transistör at, yazılımı da mükemmelleştir. Anında uzay araçlarını etkileyen yolları ve yerçekimini hesapla, ilaçlarda oluşabilecek tüm olasılıkları hesapla, hava durumu tahminlerini anında hesapla... Istekler artıyor ve çıta çok yükseliyor. Bu optimizasyonlar yetersiz kalacak diye düşünüyorum. Silikon çipler için sonu erteler.

- Katılım

- 2 Haziran 2015

- Mesajlar

- 14.295

- Makaleler

- 110

- Çözümler

- 121

Optimizasyon çözüm olsa kuantum bilgisayarlarını düşünmemize bile gerek kalmazdı. Araya fazladan transistör at, yazılımı da mükemmelleştir. Anında uzay araçlarını etkileyen yolları ve yerçekimini hesapla, ilaçlarda oluşabilecek tüm olasılıkları hesapla, hava durumu tahminlerini anında hesapla... İstekler artıyor ve çıta çok yükseliyor. Bu optimizasyonlar yetersiz kalacak diye düşünüyorum. Silikon çipler için sonu erteler.

İkili yani transistör sisteminin hesaplayamayacağı ya da hesaplasa dahi istenilen doğruluk oranına yaklaşamayacağı durumlar var. Bahsettiğin hesaplamaları sınırlayan arkalarındaki matematik ve bu matematiği elindeki sisteme entegre etmen. Transistörlere "Bana Mars'a x günde gidebielceğim en ideal rotayı hesapla" demiyorsun. Bunun bir matematik fonksiyonu vardır (ki Hohmann transferi/yörüngesi olarak geçer), bunu bir sisteme entegre edersin, girdiğin bilgilere göre sistem sana uygun fırlatma penceresini ve uygun perigee / apogee değerini verir.

Ama her şeyi ikili sisteme yani bizim şu an kullandığımız bilgisayarlara entegre edemezsin. Double Precission örneğinde verdiğim gibi, her sistemin bir doğruluk sınırı vardır. Sonuçta bu transistörler rastgele araya gelip rastgele işlemler üretmeye başlamıyor. Onları belli bir düzende sıralaman gerekiyor ve yine belli bir düzende çalıştırman gerekiyor ki, senin için gerekli olan 4 işlemi yapabilsinler. Ama bunun bir sınırı var. Hem doğruluk hem de en ideal sistemi tasarlasan bile bir hız sınırı var.

İstekler artacak, yoksa hala cam tüp kullanıyor olurduk. Teknolojinin de sınırları olacak ve tükenecek, yoksa yine hala cam tüp kullanıyor olurduk.

Sınır transistör için var ancak sistem için hala tolere edilebilir. Suyunu sıktığı şey transistör değil, işlemci ve içindeki yapı. İçindeki yapı da bir noktada insana ve onun tasarımına bağlı. Bu nedenle transistör aynı kalsa bile mimariyi değiştirmek optimizasyon değildir.

@SideWinder, sorularınızın zaten cevabını verdim. Dediğiniz şey optimizasyon olur. Var olanın suyunu sıkıyorsunuz. Tankınız 1500 beygirse 1500 beygirdir. Daha hızlı gitmesini istiyorsanız ağırlık atabilirsiniz ama bir yere kadar. Bir yerde tıkanacak.

Evet bir yerde tıkanacak ve yeni bir şeye geçmemiz gerekecek. Bunu zaten kimse inkar etmiyor ki tekrar ediyorum, en başından beri benim tartışmam bu değil. Ancak var olan dediğimiz şey tek bir transistör olmadığını, milyarlarcasından oluşan bir sistem olduğunu unutmamak gerek. Benim odaklandığım %20 IPC artışını nm düşürmeden de elde edebileceği. Senin dediğin hesaplamalar ise bundan 10 - 20 sene önce bile yarı iletkenler için imkansız görülen istatistiksel hesaplamalar.

Hava durumu dediğin şey, onlarca diferansiyel denklemden oluşan bir birleşim. Bunu daha insan olarak algılayamıyorken, insan yapımı ve insan ürünü bir mimari ile, nasıl çalıştıracaksın? Tabii şu var: Makine öğrenmesi. Bu da başka bir tartışma konusu.

Bu konuyu görüntüleyen kullanıcılar

Toplam: 2 (üye: 0, misafir: 2)

Technopat Haberler

Yeni konular

-

-

-

-

TOD TV televizyonda izleme paketi olmadan nasıl izlenir?

- yagizbboglu

- Mesaj: 1

-

-

-

-

-

-

-

-

-